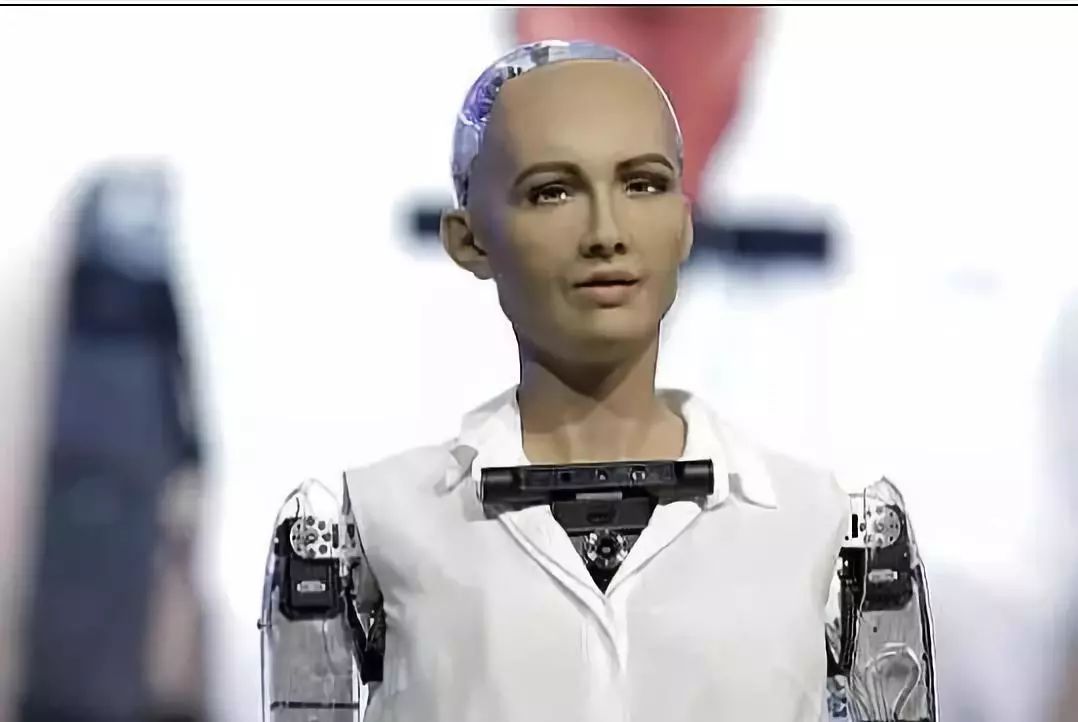

前兩年,一款叫Sophia的女性機器人火遍了全球,曝光率甚至超過了好萊塢明星,她也是世界上第一個也是目前唯一一個被授予公民身份的AI。如今,這個當紅的明星AI從今年年初開始,受到了越來越多的質疑。甚至連深度學習大佬Yann LeCun都在Twitter上公開指責Sophia是徹頭徹尾的騙子,吸引了眾多人的關注。那么,究竟什么才是真正的人工智能呢?它到底有什么樣的發展呢?

當機器人Sophia第一次出現在世人眼前的時候,全世界都沸騰了,也對它充滿了好奇。這個機器人的“性格”活潑,比如,它可以調侃深夜節目的主持人,甚至在表達時還可以像我們一樣做出生動的面部表情。可以說,Sophia就好像一個直接從科幻小說中走出來的機器人,當然,它也成為了目前我們所見過的最接近人工智能的東西。

Sophia的出現,毫無疑問,是一個令人印象深刻的工程。為了讓她能向人們學習,并作出情緒反應,其締造者漢森機器人(Hanson Robotics)以及SingularityNET為Sophia配備了先進的神經網絡,讓她成為了一個有個性的機器人。在這種情況下,Sophia也輕易作為“人類”被人們接受,比如在有關Sophia的文章中,大多數作者都使用了代詞“她”來進行描述。

“她是一個‘活體’,”漢森機器人首席執行官大衛·漢森(David Hanson)在2017年帶Sophia亮相《今夜秀》(The Tonight Show)時曾這么表示。盡管漢森機器人從未正面表明Sophia身上擁有我們在科幻小說或電影中看到的那種人工智能技術,但Sophia公開露面后,受到的所有正面或批判報道,無一例外,都對該公司的成長起到了推動作用。

隨著Sophia越來越受歡迎,人們的眼光越來越高,二者之間的信任出現了裂痕。更重要的是,隨著時間的推移,越來越多的人認為Sophia之所以總能“語出驚人”是因為它們在一定程度上是預先編寫好的。

漢森機器人的首席科學家Ben Goertzel曾表示,他對Sophia的能力并不抱任何幻想,“Sophia和其他漢森機器人并不像計算機科學研究系統那樣'純粹',因為它們以復雜的方式將許多不同部分和方面結合在了一起。換句話說,它們并不是單純的學習系統,但確實涉及到了不同層次的學習,舉個例子,在神經網絡視覺系統中學習,在OpenCog對話系統中學習等。

但有趣的是,Sophia的出現激發了公眾很多不同的反應。事實上,公眾對Sophia各個方面的看法,包括她的智慧、她的外表、她的可愛都是多種多樣的,這很值得思考。與此同時,人們對Sophia機器人的能力產生懷疑的時候,意外的也對漢森機器人以及SingularityNET增加了炒作的熱度。反過來,這兩家公司反復上演的宣傳噱頭又一次強化了這種炒作。

實際上,工業機器人維修,我們離真正的人工智能還很遠

像Sophia這樣高度宣傳的項目讓我們相信真正的(類人的)人工智能甚至可以是有意識的。但實際上,我們距離這個目標還有很長的路要走,因為人工智能研究的真實狀態遠落后于我們所相信的技術神話。如果我們現在不能以客觀的立場對待AI,那我們在這條研究的路上就不會有進步,只會永遠停留在這里。

然而,工業機器人維修,我們遇到的第一個棘手問題,就是對人工智能進行真正的定義。鑒于人工智能不斷被新的發展和變化所重塑,或許有時最好的描述方式便是解釋它不是什么。對此,數據科學家Emad Mousavi曾表示,“人們普遍認為人工智能是一個非常聰明并且什么都知道的機器人,它可以做人類所能做的任何事情。”但這并不是專家所認為的人工智能的真正定義,一般而言,AI指的是可以完成各種分析并使用一些預定于的標準作出決策的計算機程序。

人類級人工智能(HLAI)的長遠目標之一,是讓其具備有效溝通的能力以及隨著時間的推移繼續學習的能力。而目前與我們進行交互的人工智能系統,包括為自動駕駛汽車開發的系統,都是在部署之前完成所有學習,然后永久停止。對此,Facebook AI的一位研究科學家Tomas Mikolov認為,這些問題雖然目前很容易被發現,但在現在的技術支持下,卻很難解決。

整體而言,現在的人工智能還不具備自由意志,當然也是沒有意識的。至于市場上最先進的人工智能系統,也只是遵循人類定義的流程的產品,不能自己做出決定。而人們面對先進的或被過度炒作的這項技術時,往往會做出兩種假設。

比如,在包括深度學習和神經網絡的機器學習中,人們提出了一系列訓練數據的算法,該算法對任何需要它完成的任務案例展開學習,并由人類進行標記,直到它可以自己完成任務。對于面部識別軟件來說,這意味著需要將數千張面部照片或視頻送入系統,直到系統可以從未標記的樣本中準確的檢測到人臉。

另外,最好的機器學習算法通常只是記憶和運行統計模型,把它稱之為“學習”就是將操作與我們大腦完全不同波長的機器擬人化。人工智能現在是一個包羅萬象的術語,幾乎任何自動執行某項操作的計算機程序都被稱為AI。

機器學習系統實際上非常愚蠢

Facebook科學家Mikolov對此解釋道,如果訓練一個算法,讓它把兩數相加,它只會從表格中查找或復制正確的答案,卻無法從訓練中總結出對數學運算更好的理解。比如,在學會5+2=7后,人們很容易反過來思考7-2=5。但是機器無法做到這一點,也就是說要讓他學會減法,就需要重新對其進行訓練。

人工智能本來就是要經過訓練的一個系統,可以添加訓練素材,卻不能理解所添加內容的真正含義。而通常情況下,KUKA機器人示教器維修,從零開始學習要比嘗試開始新的訓練的模型更容易建立。當然,這些缺陷對AI社區的成員來說并不是秘密。但這些機器學習系統還是經常被吹捧為人工智能的最前沿。事實上,它們還是非常愚蠢。

以圖像字幕算法為例。幾年前,其中一個算法得到了一些廣泛的報道,因為它似乎產生了復雜的語言。當時,該系統的能力讓每個人都感到驚訝,但不久后,人們就發現,90%的字幕都可以在訓練數據中找到。所以,這些結果實際上并不是機器產生的,機器只是復制了它所“看”到的,即人類提供的帶有注釋的圖像。人們一直相信機器人式幽默的存在,卻不知道這只是計算機在進行復制粘貼。

夸大的宣傳中,我們要理性對待AI

那么偏離了航線的AI究竟要去往何方呢?目前的問題在于,我們現在的系統能力十分有限,但在市場上經過大肆宣傳后,公眾普遍相信我們已經擁有那項根本不知道如何去創建的技術了。

楊百翰大學(Brigham Young University)從事人工智能系統研究的計算機科學家Nancy Fulda表示,“我經常看到我的研究被媒體夸大宣傳,也有一些網站在沒有對其工作原理進行充分了解的情況下,就進行相關報道,以至于項目的技術細節被丟掉了,而研究結果卻變得異常不可思議。在某些時候,我幾乎不再認可自己的研究了。“

一些研究人員自己也會對研究結果添油加醋。然后那些沒有太多技術專長,也不關心研究背后原理的記者就成了“幫兇”,配合這些研究員進行炒作式宣傳。至于其他配角演員,就是那些創造了AI算法的人。

為什么研究員也要進行這種不誠實的炒作呢?這很重要,因為人們對人工智能研究的看法將取決于他們是否會對其進行投資。但這種毫無根據的炒作可能會阻礙該領域取得真正的進展,畢竟人工智能的金融投資與該領域的興趣水平密不可分。

當然,對算法的炒作有助于研究員推廣他們的研究成果并得到資助,而媒體也可以吸引觀眾到自己的平臺,但這對公眾來說是不公平的,因為這種惡性循環使得人們都不知道人工智能究竟能做些什么。換句話說,如果我們希望這些項目蓬勃發展,如果我們想要采取切實的方法來實現人工智能,那么該領域就需要更加透明地了解它的作用以及它的重要性!