(文/George Dvorsky)70年前,阿西莫夫提出他著名的機器人三定律,來保證機器人會友善待人。雖然最早提出時這只是個文學手法,但是有些人認為這些定律是現(xiàn)成的方案,能挽救我們免于機器末日。那么,阿西莫夫的安保措施成功經(jīng)歷了時間的考驗嗎?專家的回答是,沒有。

1942年,阿西莫夫在短篇小說"Runaround"(《環(huán)舞》)中首次提出了三定律:

一 機器人不得傷害人類,或因不作為使人類受到傷害。

二 除非違背第一定律,機器人必須服從人類的命令。

三 除非違背第一及第二定律,機器人必須保護自己。

但后來,阿西莫夫加入了一條新定律:第零定律。

零 機器人不得傷害人類整體,或因不作為使人類整體受到傷害。

阿西莫夫的科幻設定里,機器人三定律是植入到近乎所有機器人軟件底層里,KUKA機器人電路板維修,不可修改不可忽視的規(guī)定,絕不僅僅是“建議”或者“規(guī)章”。但是顯然這不是一個物理定律,所以現(xiàn)實中的機器人并不遵守——至少暫時如此。

正如阿西莫夫許多小說里顯示的,這三條定律的缺陷、漏洞和模糊之處不可避免會導致一些奇怪的機器人行為。比方說,www.twshmhelmet.com,這三條定律連何為“人”、何為“機器人”都沒有良好定義。而且,如果機器人獲取的信息不完整,它們完全可以無意中打破定律。更何況,你要怎么阻止一個智力超群的機器人自己把定律改掉呢?

因此,機器人維修,很多人都認為這只是單純的推動劇情用的寫作手法而已。但是,1981年,阿西莫夫本人在《Compute!》里說:

“……有人問,我是不是覺得我的三定律真的可以用來規(guī)范機器人的行為——等到機器人的靈活自主程度足以在不同的行為方式中選擇一種的時候。我的答案是,‘是的,三定律是理性人類對待機器人(或者任何別的東西)的唯一方式’。”

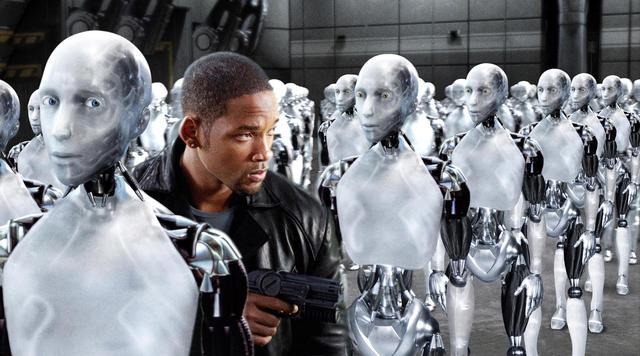

好吧,三十年過去了,我們的機器人——準確地說,是操縱機器人的人工智能——真的在逼近阿西莫夫所說的那一天。事實上,人工智能恐怕再過一段時間就要抵達技術奇點,發(fā)生爆炸式增長,徹底把人類智能甩在后面。

而如果這樣一個超級智能的程序編得不夠好,或者它不在乎人類的需求,那么對我們而言就是徹頭徹尾的災難。我們必須保證它是安全的。

那么,阿西莫夫三定律可以幫我們嗎?我們采訪了兩位人工智能理論研究者:本·格策爾(Ben Goertzel),艾迪亞金融預測公司首席科學家;路易·海爾姆(Louie Helm),機器智能研究所代理主任。他們的觀點是,阿西莫夫三定律完全不能勝任——而如果我們想保證超級智能的安全,我們需要一些全然不同的東西。

阿西莫夫的未來

“我認為阿西莫夫預想的機器人過不了多久就會實現(xiàn)。”格策爾說,“但是在他大部分小說里,看起來人類級別的機器人好像就是機器人學和AI工程的頂峰了。事實看起來并非如此。在抵達阿西莫夫式類人機器人之后,很快超人AI也會成為可能。”

典型的阿西莫夫未來里,大部分生活都如常——只不過多了些人形智能機器人走來走去而已。“但這種未來不太可能實現(xiàn)——或者就算是它實現(xiàn)了,也只會存在很短的時間,”他說。

在海爾姆看來,機器人根本無關緊要。

“我認為對人類來說最主要的問題,不是一大群半智能人形機器人所需的道德規(guī)范,而是高階人工智能最終會出現(xiàn)(不管有沒有軀體),其功能遠遠超過人類水平。”海爾姆說,“人類早晚必須要跨過超級智能這個坎。這也是為何開發(fā)安保措施如此重要。在我看來,機器人、仿生人、模擬大腦什么的都無關緊要,我們最多和它們相處一二十年,之后就要面對真正的大問題——為超級智能開發(fā)倫理道德。”

好的開端?

鑒于阿西莫夫三定律是第一個真正試圖解決人工智能行為問題的方案,那么就算是超級人工智能,它能不能也起到一定效果——或者至少有所啟迪呢?

“老實說,我真沒從機器人三定律里獲得什么靈感。”海爾姆說,“機器倫理學的共識是,它無法成為機器倫理的合適基礎。”三定律的確廣為人知,但現(xiàn)實中無論是AI安全研究者還是機器倫理學家,都沒有真的使用它作為指導方案。

“原因之一是這套倫理學——我們稱之為‘義務倫理學’(deontology)——作為倫理基礎是行不通的。依然有幾個哲學家試圖修復義務倫理學體系,但同一批人常常也熱衷于‘智能設計’或者‘神命論’之類的東西。”海爾姆說,“沒幾個人嚴肅對待他們。”

他總結了三定律的幾處缺陷:

內在的對抗性

基于有缺陷的倫理框架(義務倫理)

不被研究者接受